요즘 따라 데이터를 많이 사용해 요금제를 무제한 요금제로 바꿨다.

그런데 이 무제한이 완전한 무제한이라고 써져 있는데 완전 무제한이 아니다.

테더링이나 핫스팟을 사용하면 사용량을 측정해서 공유데이터에 반영이 되고 이 공유 데이터를 다 쓰면 핫스팟을 사용할 수가 없다.

그래서 핫스팟 제한을 우회하려고 찾아봤으나 웬만한 것들은 다 막혀 있다.

그래서 인터넷을 더 찾아보다 보니까 아이폰에 프록시 서버를 만들어서 아이폰에서 접속하는 것처럼 만들면 핫스팟 제한을 우회할 수 있다는 것을 알게 되었다.

nneonneo/iOS-SOCKS-Server: iOS HTTP/SOCKS proxy server for fake-tethering

누군가가 이렇게 아이폰에서 프록시 서버를 만들 수 있게 해 두었다.

나는 이걸 쓰기로 했다.

문제는 이것을 쓰려면 파이썬을 실행할 수 있는 앱이 필요한데 이 앱이 유료다.

14,000원이나 한다마는 값어치는 있다고 생각했다.

우선 저 GitHub 페이지에서 Code 를 눌러 Download ZIP 을 해서 소스코드를 받는다.

그러면 파일앱의 다운로드에 가면 ZIP 파일이 있는데 이것을 압축을 풀어준다.

그리고 Pythonista 3 을 다운로드 받으면 파일에서 iCloud 에 Pythonista 3 폴더가 생기는데 여기로 압축을 푼 파일을 넣어준다.

이제 핫스팟을 켠 다음 Pythonista 3 를 실행해서 socks5.py 를 실행해 주면 된다.

이제 맥에서 연결을 해 보겠다.

우선 IP를 수동으로 설정해 줘야 하니 나중에 편하게 바꿀 수 있게 위치를 추가해 줄 것이다.

설정 > 네트워크 > … > 위치 > 위치 편집 으로 들어간다.

+ 버튼을 눌러 위치를 새로 생성해 준다 나는 iPhone Hotspot 으로 설정했다.

이제 Wi-Fi 로 가서 아이폰 핫스팟을 연결한다.

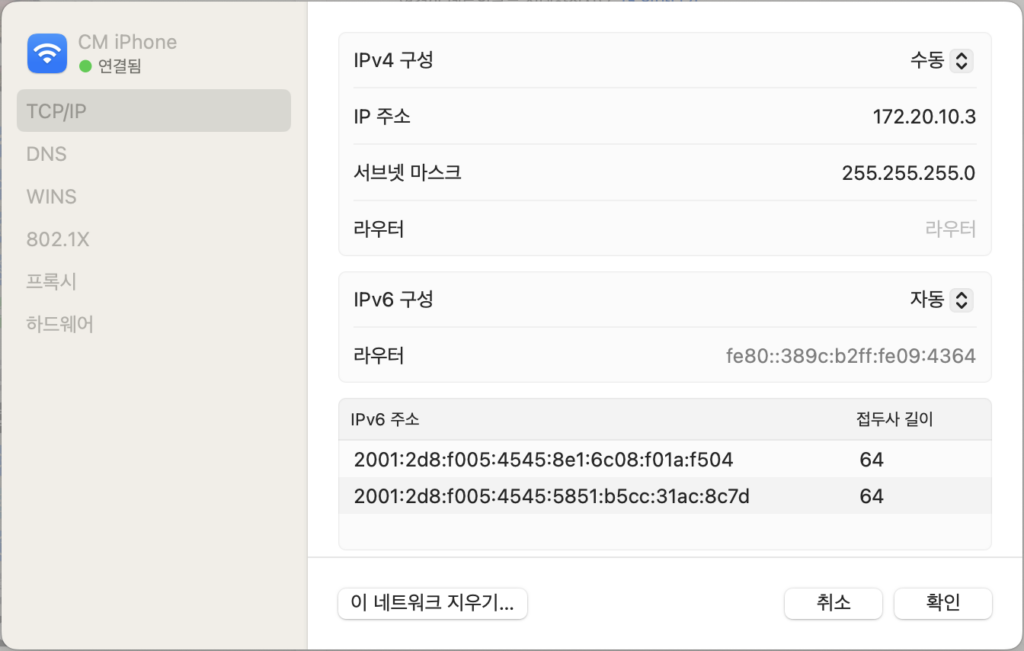

세부사항 > TCP/IP 로 들어간다.

IPv4 구성을 수동으로 바꾸고 IP 주소를 172.20.10.X 서브넷 마스크를 255.255.255.0 으로 설정한다. 여기서 X는 2-254 사이의 숫자를 입력하면 된다.+20250420

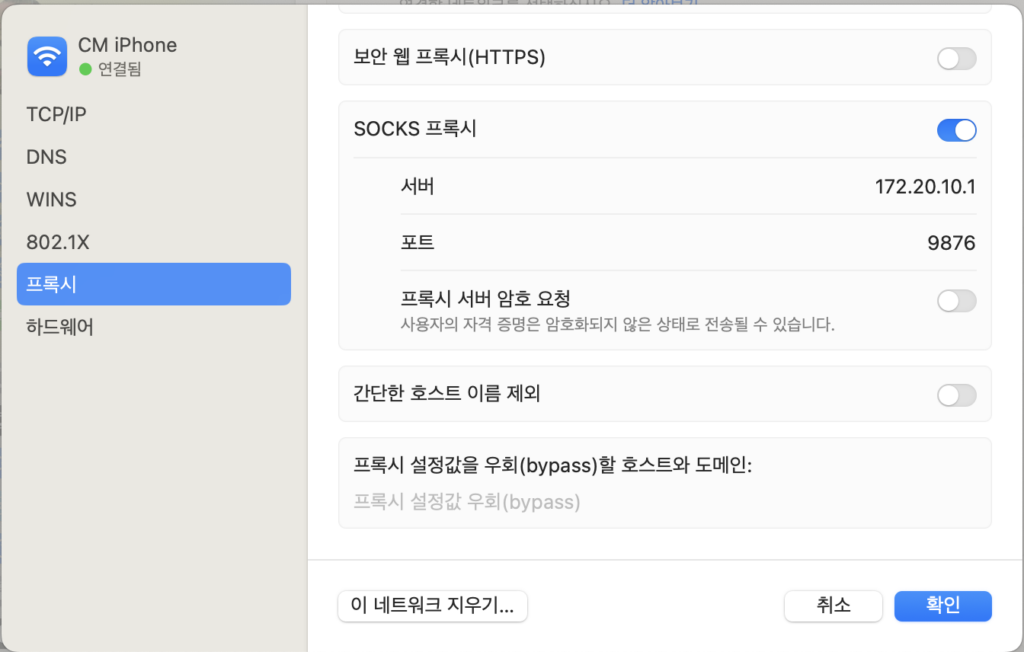

그다음 프록시로 가서 SOCKS 프록시를 켜주고 아이폰에 나오는 SOCKS Address 를 입력해 주면 된다 기본값은 서버 172.20.10.1 에 포트 9876 일것이다.+20250428

이렇게 설정하면 끝이다.

맥에서 웹사이트나 유튜브 등을 보면 아이폰의 프록시 서버를 통해서 통신해서 공유데이터 사용량에 집계가 안된다.

허나 단점이 있는게.

- 앱을 계속 실행하고 있어야 한다. 다행히도 실행하는 동안 화면이 꺼지지는 않는다.

- 모든 트래픽이 우회 되는 것은 아니다. 실험해 보니 디스코드는 안된다.+20250408

그래도 이 정도면 쓸 만하다고 생각한다.

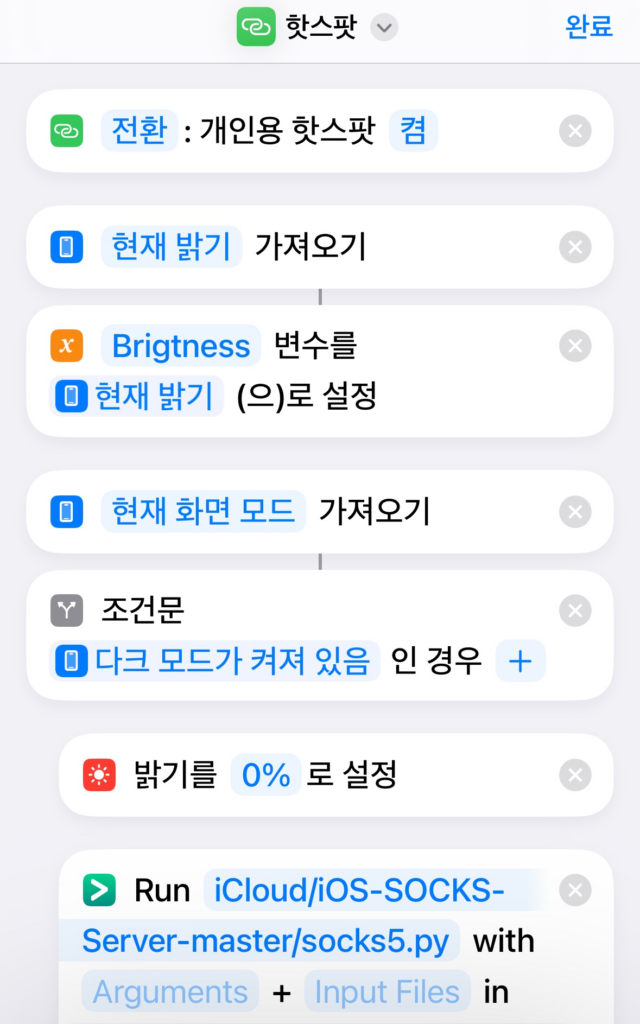

참고로 단축어에 등록을 해서 탭하면 핫스팟이랑 프록시 서버가 자동으로 켜지게끔 해 둘 수 있다.

필요한 사람은 아래에 단축어 링크를 올렸으니 참고 바란다.

=== 2025-03-07 추가내용 ===

아이폰을 유선으로 테더링 하면 IP 주소를 수동으로 설정할 수가 없는데 터미널로 설정할 수 있다.

sudo networksetup -setmanual "iPhone USB" 172.20.10.X 255.255.255.0X 값에 2-254 사이의 원하는 숫자를 넣어준다 (다른 기기와 겹치면 안된다)+20250420

sudo networksetup -setsocksfirewallproxy "iPhone USB" 172.20.10.1 9876

sudo networksetup -setautoproxyurl "iPhone USB" http://172.20.10.1:8088/wpad.dat첫번째 줄은 SOCKS5 프록시를 설정하는것이고

두번째 줄은 자동 프록시 구정을 설정하는 것이다.

이 값을 설정을 안하면 파이어폭스에서 인터넷이 안 되길래 설정했다.

sudo networksetup -setproxybypassdomains "iPhone USB" localhost,.local,127.0.0.1,192.168.0.0/16,172.16.0.0/12,10.0.0.0/8위 설정은 프록시 설정값을 우회(bypass)할 호스트를 설정한 것이다.

=== 2025-04-08 추가내용 ===

디스코드 같은 트래픽도 우회 시킬 수 있는 방법이 있다.

NordVPN 같은 VPN 서비스를 사용하면 VPN 을 수동으로 연결할 수 있는데

OpenVPN Connect 같은 앱을 깔아서 수동으로 VPN 구성을 추가해 준 다음 프록시를 아이폰의 프록시서버로 설정해 주면 된다.

그러면 대부분의 트래픽은 프록시 서버로 통신하고 나머지 트래픽도 프록시 서버를 통해 VPN으로 통신한다.

=== 2025-04-20 추가내용 ===

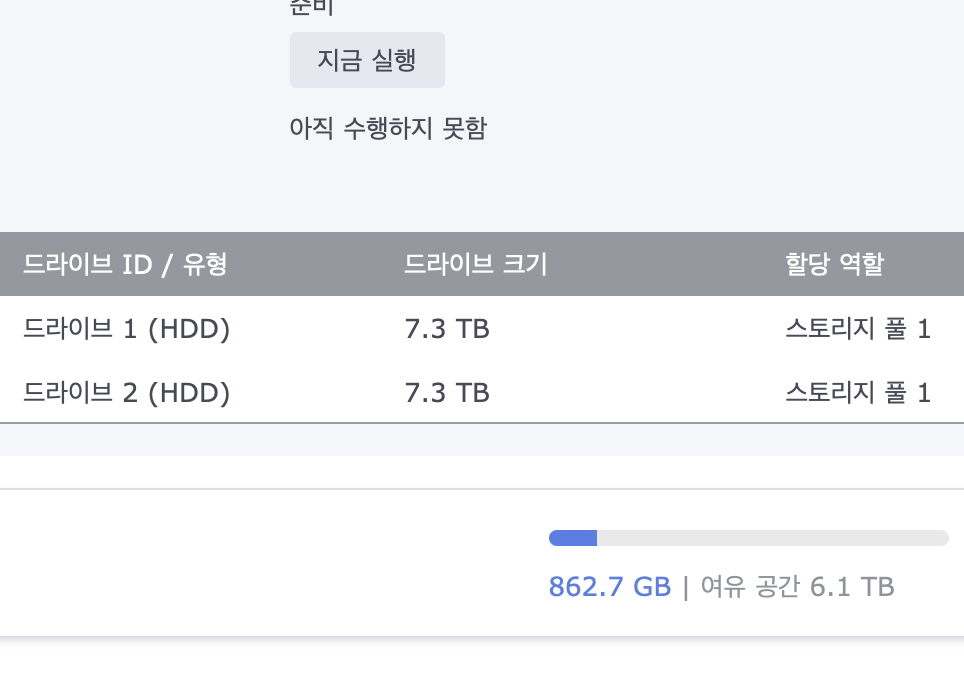

아이폰 핫스팟의 서브넷 마스크는 255.255.255.240 이다.

따라서 네트워크 설정할 때 서브넷 마스크를 255.255.255.240 (네트워크 식별자 길이: 28)으로 설정하고 IP주소는 172.20.10.2 – 172.20.10.14 의 값을 입력해야 한다.

이 포스트는 SKT + 아이폰15 기준으로 작성되었다. 다른 통신사는 안되는 것 같다고 하는데. 나중에 지인 폰으로 테스트 해 보고 내용을 추가해 보겠다.

===2025-04-28 추가내용===

윈도우 프록시 설정법:

설정 > 네트워크 및 인터넷 > 프록시 > 자동 프록시 설정 > 설정 스크립트 사용 편집

설정 사용 스크립트 사용 체크 한 다음에 스크립트 주소에 PAC URL 주소를 적는다. (http://172.20.10.1:8088/wpad.dat)

갤럭시 프록시 설정법:

설정 > 연결 > Wi-Fi > 아이폰 핫스팟 옆 톱니바퀴 > 더보기

프록시를 수동으로 설정하고 HTTP Proxy Address를 프록시 호스트 이름과 프록시 포트에 적는다. (주소: 172.20.10.1 포트: 9877)

아이폰 프록시 설정법:

설정 > Wi-Fi > 아이폰 핫스팟 옆 i 버튼 > 프록시 구성

자동으로 설정 후 PAC URL을 URL 값에 적는다. (http://172.20.10.1:8088/wpad.dat)